Bonjour,

Je vais essayer de te fournir de quoi faire, mais il faudra que tu te penches un peu sur le code.

Je ne sais pas ce que tu connais en programmation, donc j'espère ne pas t'offenser avec des évidences si tu connais déjà la suite ...

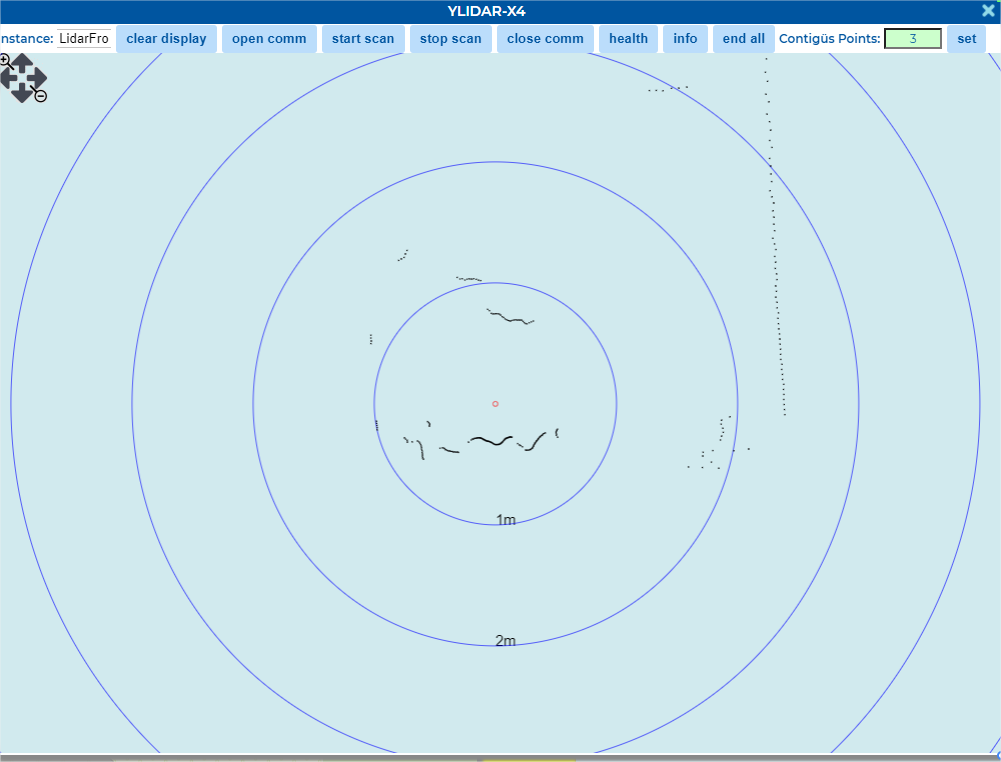

1) je te fourni un ensemble de sources en html/js que j'ai en partie écrit (vite fait) pour des ballades avec des amis. Le but était de décrire des points d'intérêt (POI) sur une carte, sans la complexité de Google Map.

On choisit le type de carte, on clique pour ajouter des POI, on peut les commenter (clic droit) et les supprimer, et sauvegarder l'ensemble dans un fichier que l'on peut recharger.

J'ai juste ajouter pour toi le "tracé" d'un polygone reliant les POI.

Le principe des données manipulée est toujours le format JSON. Le contenu du fichier est chargé comme une chaine, la fonction JSON.parse le convertit en une structure json. On le sauvegarde en convertissant le json en chaine avec la fonction JSON.stringify.

Il te faudra donc que ton tableau de structure soit plutôt au format JSON. Si tu ne connais pas, c'est vraiment simple à faire :

- accolade-ouvrante,

- mot-clé, deux-point,

--> soit valeur-chaine (entre double quote), soit numérique telle-quelle,

--> soit une sous-structure (accolade, etc...), soit un tableau ( crochet ouvrant, valeur, virgule, valeur... crocher-fermant)

--> soit un tableau

- accolade-fermante.

2) Pour utiliser le tout, il faut :

- dezipper MapWalker dans un répertoire

- lancer le mini serveur http depuis une fenêtre console et contenu dans ce même répertoire (maintSmallHttpServer.cmd , qui lance lui-même miniweb.exe avec les bons paramètres)

- lancer ensuite, depuis chrome, "http://127.0.0.1:8000/MapWalker.html"(en 127.0.0.1 puisque le serveur web vient d'être lancé sur ta machine).

- tu peux tester l'outil en chargeant le fichier "MapWalker\MapWalker-2021-12-19 11_06_24.json" donné en exemple.

Ensuite, à toi d'adapter le code pour tes propres données.

- la fonction "processLoadParcoursFile()",

- elle même appelant MWParcours.loadFromData pour ajouter tous les points à l'objet parcours

- qui lui-meme crée des MWPoint "accroché à la carte (this.marker = L.marker( this.pos, ... ).addTo( this.mapView)

Si tu ne sais pas comment debugger du js :

- tu modifies le code avec un éditeur de texte quelconque.

- sous chrome, tu appuie sur F12 pour afficher le debugger

- tu sélectionne l'onglet "Sources" pour choisir le fichier à inspecter (le html principal ou un sous-module en .js)

- tu accède au fichier,

- tu pose un point d'arrêt en cliquant à gauche du n° de ligne

- tu recharges la page avec F5

- tu avance pas-à-pas avec F0, tu entres dans une fonction avec F11

- tu poursuis l'exécution avec F8.

Ce code est utilisable pour analyser tes données.

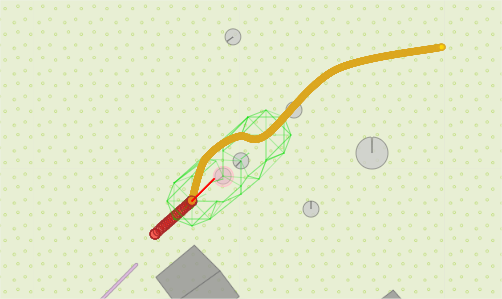

Tu pourrais utiliser quasiment le même si tu étais connecté en Websocket à ton robot, et que celui-ci t'envoyais en temps-réel les nouveaux points découvert.

NB : Pour indication, le mini serveur web est : MiniWeb (build 300, built on Feb 28 2013) ©2005-2013 Written by Stanley Huang <stanleyhuangyc@gmail.com>

J'espère ne pas avoir été trop à côté de la plaque.

Bonsoir.

![]()